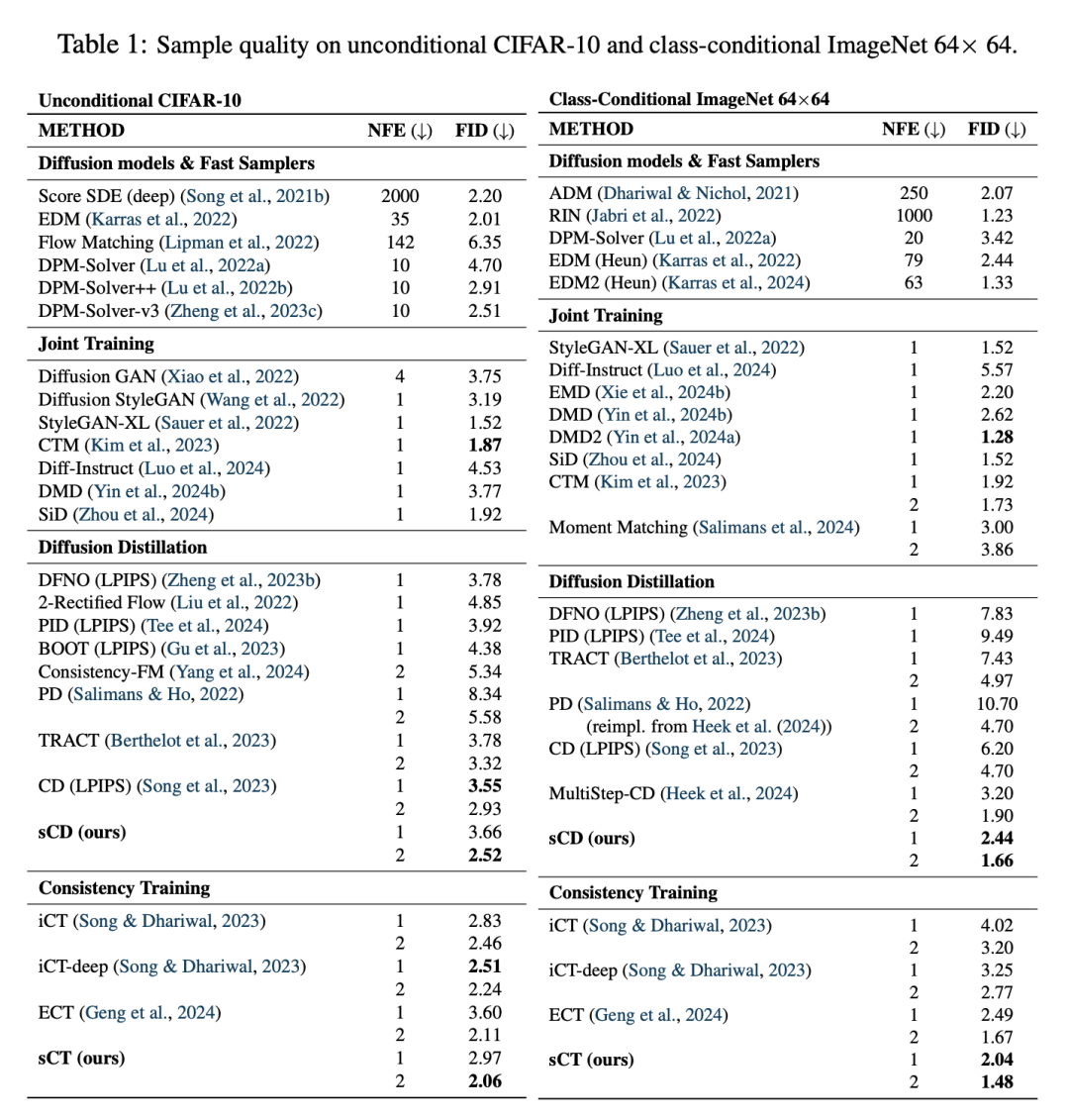

多项改进实现规模空前的连续时间一致性模型。

论文标题:Simplifying, Stabilizing & Scaling Continuous-Time Consistency Models 论文地址:https://arxiv.org/pdf/2410.11081v1

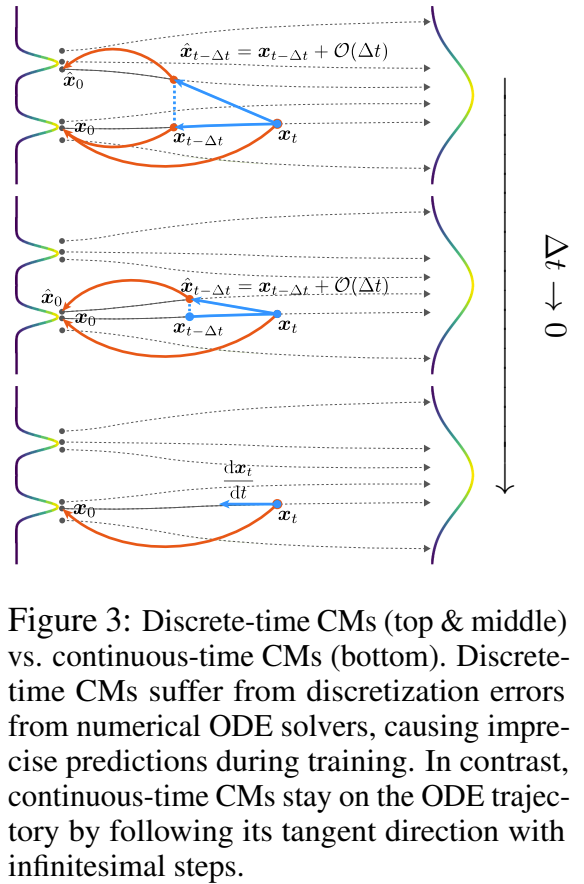

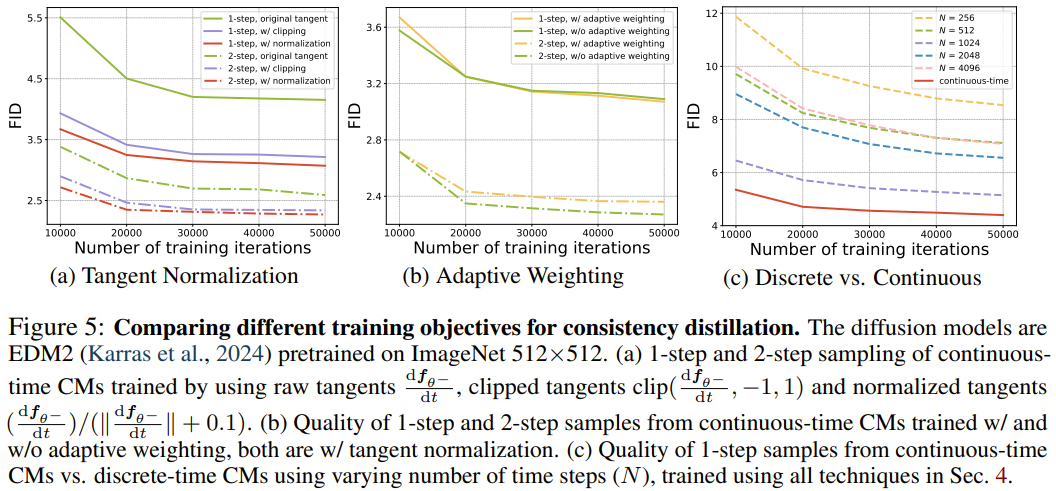

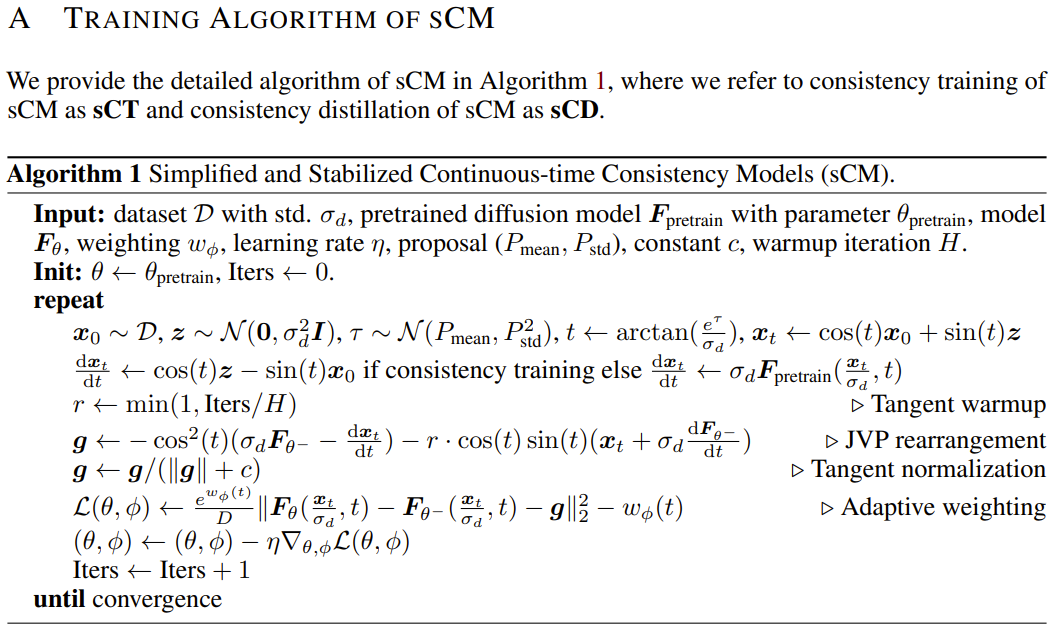

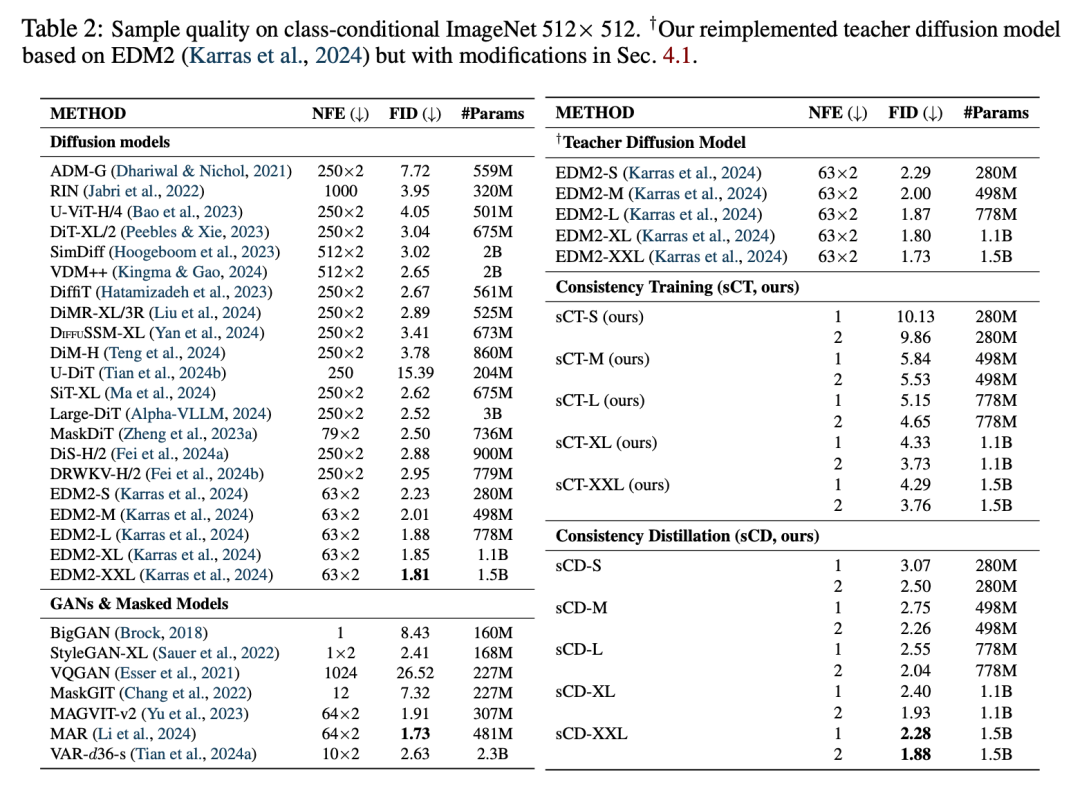

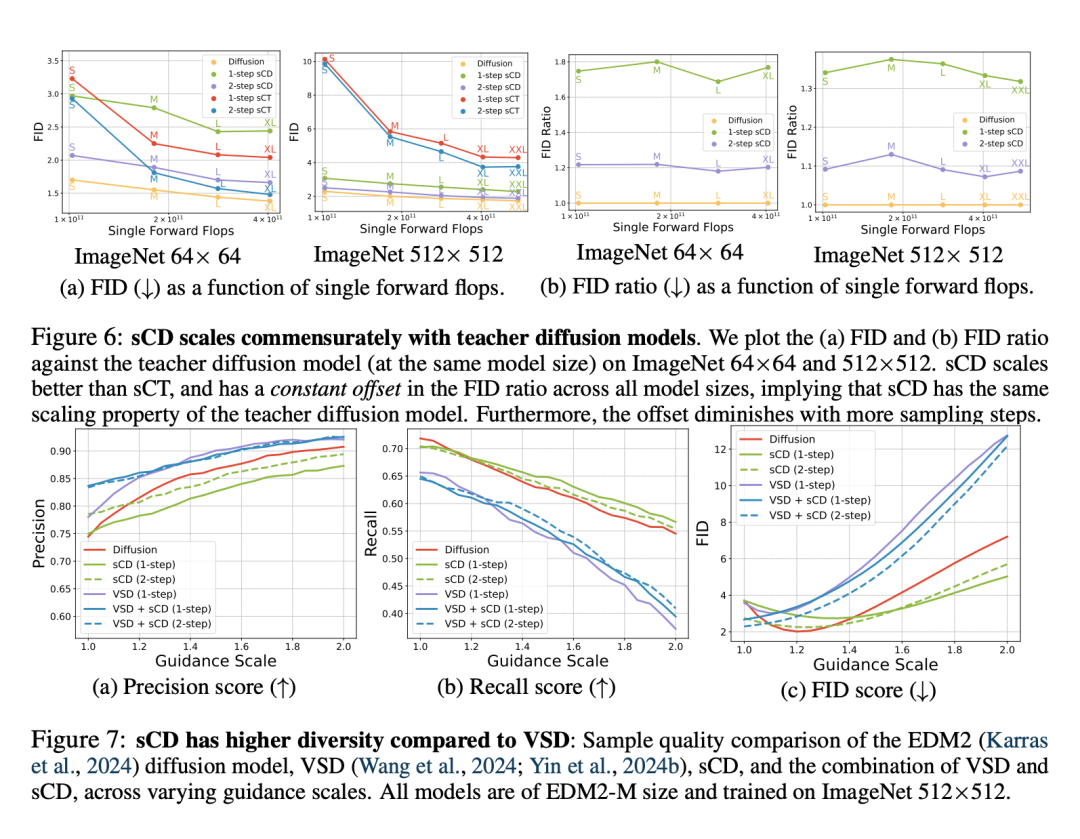

TrigFlow,一个将 EDM(arXiv:2206.00364)与流匹配(Flow Matching)统一起来的公式,其能极大简化扩展模型、相关的概率流 ODE 和一致性模型(CM。 在此基础上,他们分析了一致性模型训练不稳定的根本原因,并提出了一种完整的缓解方案。他们的方法包括改进网络架构中的时间调节和自适应分组归一化。 此外,他们还重新构建了连续时间 CM 的训练目标,其中整合了关键项的自适应加权和归一化以及渐进退火,以实现稳定且可扩展的训练。

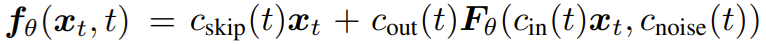

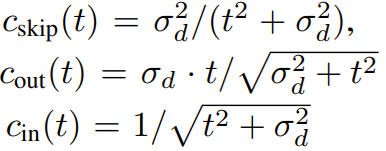

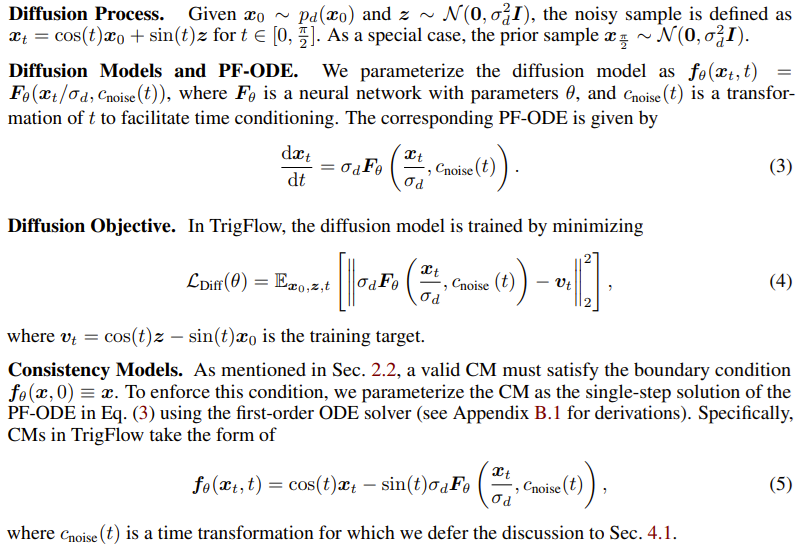

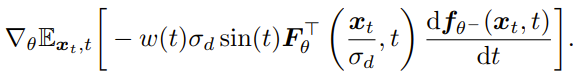

,而在 TrigFlow 框架下,该正切函数由以下公式给出:

,而在 TrigFlow 框架下,该正切函数由以下公式给出:

表示 PF-ODE,其要么在一致性蒸馏中使用预训练的扩散模型估计得出,要么就在一致性训练中使用从噪声和干净样本计算得到的无偏估计器估计得出。

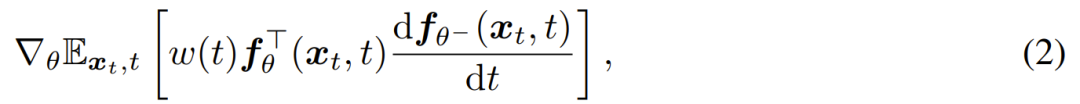

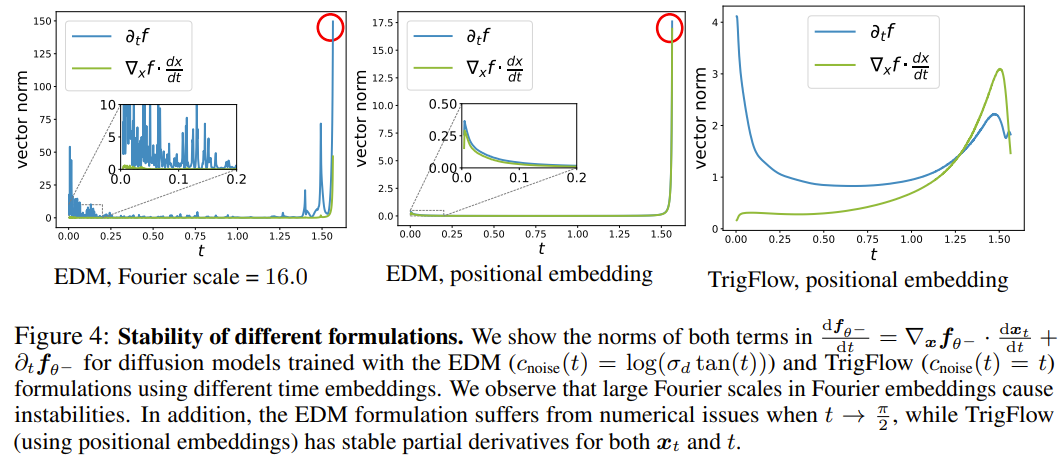

表示 PF-ODE,其要么在一致性蒸馏中使用预训练的扩散模型估计得出,要么就在一致性训练中使用从噪声和干净样本计算得到的无偏估计器估计得出。 通常经过良好调节。因此不稳定的来源是时间导数

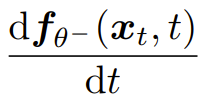

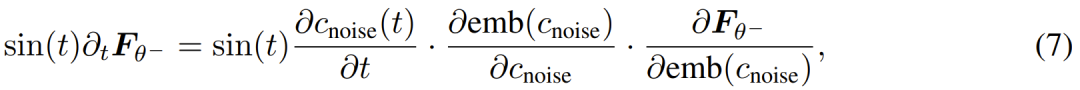

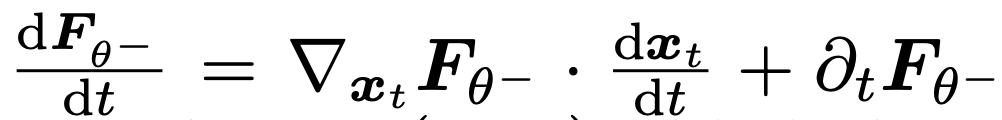

通常经过良好调节。因此不稳定的来源是时间导数  ,而其可被分解为:

,而其可被分解为:

,我们需要提高数值精度,同时支持高效记忆注意力计算,详情如下。

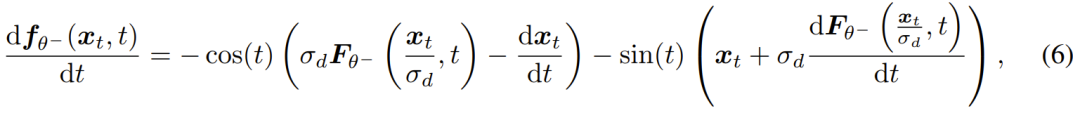

,我们需要提高数值精度,同时支持高效记忆注意力计算,详情如下。 时,需要计算

时,需要计算  ,这可通过

,这可通过 与输入向量

与输入向量  和正切向量

和正切向量  的雅可比向量积(JVP)高效获得。然而根据经验,当 t 接近 0 或 π/2 时,正切可能会在中间层溢出。为了提高数值精度,研究者认为应该重新安排正切的计算。

的雅可比向量积(JVP)高效获得。然而根据经验,当 t 接近 0 或 π/2 时,正切可能会在中间层溢出。为了提高数值精度,研究者认为应该重新安排正切的计算。 ,而

,而  与

与  成正比,因此可以这样计算 JVP:

成正比,因此可以这样计算 JVP:

的 JVP,输入为

的 JVP,输入为 ,正切为

,正切为 这种重新排列大大缓解了中间层的溢出问题,使 FP16 的训练更加稳定。

这种重新排列大大缓解了中间层的溢出问题,使 FP16 的训练更加稳定。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...