极市导读

实验结果表明,PGv3 在文本提示的准确性、复杂推理和精确的文本渲染方面表现优异。用户偏好研究表明,PGv3 在常见的设计应用 (如贴纸、海报和徽标设计) 中具备超越人类的图形设计能力。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

本文目录

1 Playground v3:Deep-Fusion,一个策略实现 T2I 模型更好的图文对齐

(来自 Playground Research)

1 Playground v3 论文解读

1.1 Playground v3 简介

1.2 Playground v3 模型架构

1.3 Playground v3 模型训练

1.4 图像字幕模型 PG Captioner

1.5 图像质量的定性评价结果

1.6 图像质量的定量评价结果

太长不看版

本文提出的 Playground v3 (PGv3) 是 Playground Research 团队于 2024.09 推出的最新 text-to-image (T2I) 模型,在多个测试基准上达到了 SoTA 性能。Playground v3 不像传统依赖 LLM (比如依赖于 T5 或者 CLIP 文本编码器) 的 T2I 模型,它完全整合了 LLM。Playground v3 通过一种新颖的 Deep-Fusion 结构,独立地从 decoder-only LLM 中获取文本条件。此外,为了提升图像字幕的质量,作者开发了一个内部的字幕生成器,能够生成具有不同细节层次的字幕,丰富了文本结构的多样性。作者还引入了一个新的基准 CapsBench,用于评估详细的图像字幕生成性能。实验结果表明,PGv3 在文本提示的准确性、复杂推理和精确的文本渲染方面表现优异。用户偏好研究表明,PGv3 在常见的设计应用 (如贴纸、海报和徽标设计) 中具备超越人类的图形设计能力。此外,PGv3 还引入了新的功能,包括精确的 RGB 颜色控制和强大的多语言理解能力。

1 Playground v3:Deep-Fusion,一个策略实现 T2I 模型更好的图文对齐

论文名称:Playground v3: Improving Text-to-Image Alignment with Deep-Fusion Large Language Models

论文地址:

http://arxiv.org/pdf/2409.10695

1.1 Playground v3 简介

大规模文生图模型的架构从传统的基于 U-Net 的模型[1]转移到基于 Transformer 的模型[2]。这项工作在此基础上开发了一种新的基于 DiT 的扩散模型并将其缩放到 24B 参数。作者进一步提出了一个 Deep-Fusion 架构,以利用现代仅解码器的 LLM[3]的知识来生成文生图的任务。

第 1.2 节中,作者描述了简化的模型架构、噪声调度和新的变分自动编码器 (VAE)。新的 T2I 模型结构的特点是 LLM 的深度集成,充分利用 LLM 的内部提示理解来实现最先进的提示跟随性能。1.3 节讨论了模型训练细节,包括在预训练阶段使用多级字幕和模型合并。1.4 节介绍了我们的内部字幕器和一个新的字幕基准 CapsBench。

第 1.5 节中,作者展示了本文模型在 5 个关键方面的能力的定性示例:照片现实主义、提示跟随、文本渲染、RGB 颜色控制和多语言理解。

1.2 Playground v3 模型架构

文本编码器

Playground-v3 (PGv3) 是一种使用 EDM[4]范式训练的 Latent Diffusion Model (LDM)[5],服务于文生图 (T2I) 任务。与之前的 DALL-E 3, Imagen 2, 和 Stable Diffusion 3。不同的是,它不使用常见的文本编码器 (Text Encoder),比如 T5[6]或者 CLIP[7],而是集成了大语言模型 (LLM),尤其是 LlaMA3-8B[3],以增强其在即时理解和后续方面的能力。

一些研究工作[8][9][10][11]也希望利用 LLM 来提高 T2I 模型的指令对齐的能力,比如使用 LLM 作为文本编码器来替换常用的 T5 和 CLIP,或者使用 LLM 来适配或者修改 Prompts。PGv3 使用的是前一种方法:不使用 T5 或者 CLIP 等文本编码器,紧紧依靠 LLaMA3-8B 为 Diffusion 模型提供 text condition。

对于预训练的文本模型,作者在使用时采取了一种非常不同的策略。标准的做法是使用 T5 Encoder 或者 CLIP Text Encoder 的最后一层的输出。Transformer 的每一层都有不同的表征[12][13],包含不同级别的单词级和句子级的信息。但是作者发现调节 T2I 模型的最佳层可能很麻烦,尤其是对于 Decoder-only 的 LLM 而言。由于其复杂的内部表征,才使其具有优越的生成能力。

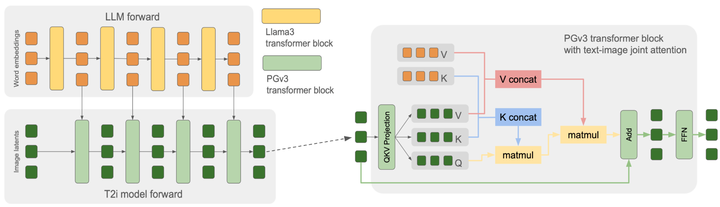

作者认为,信息流在 LLM 中每一层的连续性使其具有了强大的生成能力。换句话讲,LLM 中的知识跨越其所有的层,而不是任何单层的输出可以描述的。受到这一启发,作者设计了 T2I 的模型架构,使其复制 LLM 内的所有 Transformer Block。这种设计允许本文模型将来自 LLM 的每个对应层的 Hidden Embedding 作为输入 T2I 模型每一层的 condition。作者认为这种方法充分利用了 LLM 完整的思考过程,指导 T2I 模型反映 LLM 的推理和生成过程。因此,本文模型在生成图像时实现了很好的 Prompt following 的能力。

模型架构

Playground v3 整体基于 DiT-style[14]架构。在 PGv3 的图像模型中,每个 Transformer Block 被设置为与 LLM (LlaMA3-8B) 中的相应 Block 相同,包括 hidden dimension、attention head 数量和维度等参数。作者只训练了图像模型,保持 LLM 不变。注意在扩散采样过程中,LLM 部分只需要运行一次以生成所需的所有中间 hidden embedding。

简化版的 PGv3 架构如图 2 所示。每个 Transformer Block 只包含一个 Attention 层和一个 FeedForward 层,反映了 LlaMA3 的结构。与大多数传统的基于 CNN 的扩散模型[5]不同,这些模型通常将图像特征的 Self-Attention 与图像特征之间的 Cross-Attention 分开。但是本文不一样,本文作者使用了一个单一的 Joint Attention 操作:Image Query 关注 Image Key 和 Text Key 的串联,使其能够从 Image 和 Text 值的组合池中提取相关特征。这种 Joint Attention 设计的主要动机是希望降低计算成本和推理时间。

虽然最终确定了我们的模型设计,并在 SD3[15]发表之前开始训练,但作者观察到,如果把相应的 LLM Block 和 Image Block 视为 PGv3 中的单层时,PGv3 Transformer Block 与 SD3 中提出的 MMDiT 具有相似的设计哲学。这种哲学为,在所有的 Block 中使得图像和文本特征之间的集成和连续交互的思想。而且,本文的设计更简单,更彻底地利用了文本编码器。

有许多研究工作旨在探索更好的模型结构,例如 Hunyuan-DiT[16],Pixart-α[17]。作者对 PGv3 进行了几次结构的调整,但没有观察到大多数存在明显的好处。这里作者报告了这个过程中发现有用的一些设计,并合并到最终模型的设计中。

U-Net Transformer Block 之间的 Skip-connections。 作者在所有 Image Block 上应用 U-Net Skip-connection,如之前在 U-DiT[18]中尝试的那样。

中间层的 Token Downsampling。 在 32 层中,作者将图像 Key 和 Value 的序列长度减少了 4 倍,使整个网络类似于传统的卷积 U-Net,只有一层下采样。这种调整略微加快了训练和推理时间,因此没有观察到任何性能下降。

位置编码。 作者使用了传统的旋转位置编码 (RoPE)[19]。由于使用二维图像特征,作者采用了 RoPE 的 2D 版本。之前的几项工作已经探索了 2D-RoPE 的变体;在本文研究中,作者主要尝试了 2 种类型,称之为 “interpolating-PE” 和 “expand-PE”。

“interpolating-PE” 方法保持开始和结束位置 ID 固定,而不管序列长度如何,并在两者之间插入位置 ID,这也是SD3 等模型采用的想法。而 “expand-PE” 方法以序列长度按比例增加位置 ID,无需应用任何技巧或归一化。

作者发现 “interpolating-PE” 有一个显著的缺点:导致模型在训练分辨率上严重过拟合,无法泛化到看不见的纵横比。相比之下,”expand-PE” 方法表现良好,没有分辨率过拟合的迹象。因此,作者选择最后使用传统的位置编码。

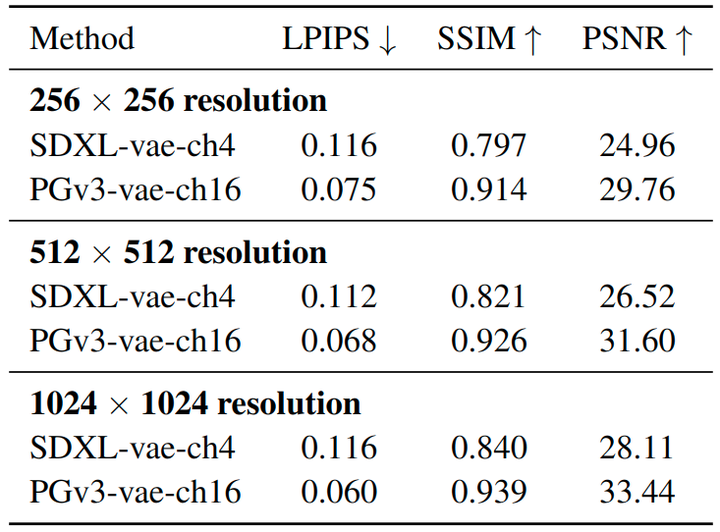

模型 VAE

LDM 中使用的变分自动编码器 (VAE) 在确定模型对细粒度图像质量的上限方面起着至关重要的作用。Emu[20]的作者将 VAE latent channel 从 4 增加到 16,从而提高了合成更精细的细节的能力,特别是对于较小的人脸和单词。按照这种方法,作者用 16 个通道训练了内部 VAE。此外,作者没有仅在 256×256 分辨率下进行训练,而是将训练扩展到 512×512 分辨率,这进一步提高了重建性能。

作者尝试结合 Emu 的 VAE 训练中提出的频率方法,但没有观察到任何性能改进。此外,作者探索了更积极的 VAE 修改,包括使用预训练的 Image Encoder,如 CLIP 的 Image Encoder。但是,尽管这些方法产生了具有相当重建能力的 VAE,但这些预训练的 Image Encoder 生成的 latent space 导致扩散训练不稳定,因此没有进一步探索。

1.3 Playground v3 模型训练

Noise Schedule

尽管 Flow Matching 模型[21][22][23]最近出现的比较多,但 Playground v3 模型继续使用 EDM[4]schedule,与 PGv2.5 保持一致。作者称不使用 Flow Matching 没什么具体的原因,只是使用 EDM schedule 没有遇到任何性能限制。与此同时,作者对 EDM2[24]中提出的动态时间戳加权技术进行了实验,该技术针对 EDM schedule 量身定制。不幸的是,没有观察到任何显着的性能提升。作者怀疑这可能是由于模型大小和数据的差异,因为本文的训练规模远大于 EDM2 中使用的 ImageNet 训练设置。

多 Aspect-Ratio 支持

继之前在 PGv2.5[25]中的工作之后,本文采用了多 Aspect-Ratio 训练策略。作者从 256×256 低分辨率下的正方形图像训练开始,并在更高分辨率的 512×512 和 1024×1024 像素尺度上使用在线桶策略。

图像多级字幕

作者开发了一个内部视觉大语言模型 (VLM) 字幕系统,能够生成高度详细的图像描述,包括小物体、照明、风格和视觉效果。作者在这个内部字幕器 (PG Captioner) 上运行基准。结果表明,本文模型在多个特定于图像的类别中优于其他模型。

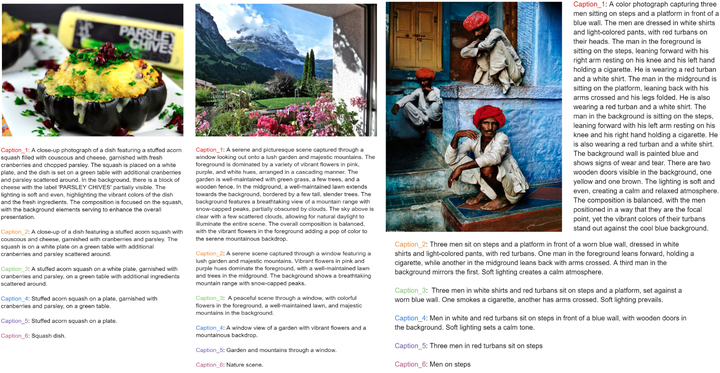

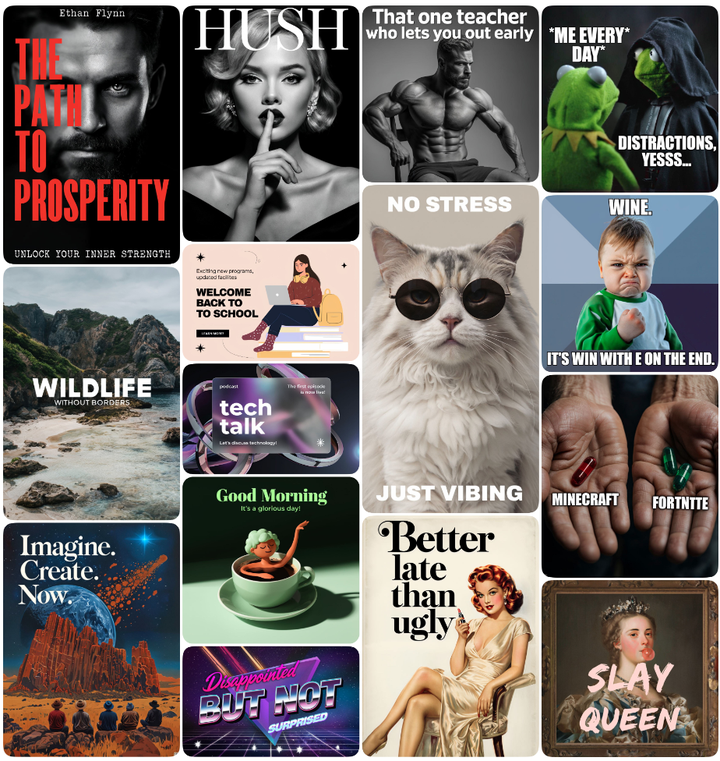

本文作者通过生成多级字幕来减少数据集 bias 并防止模型过拟合,进一步改进了这些字幕条件。如图 3 所示,对于每个图像,作者合成了 6 个不同长度的字幕,从细粒度细节到粗略概念。在训练期间,在不同的迭代中为每个图像随机抽取这 6 个字幕之一。

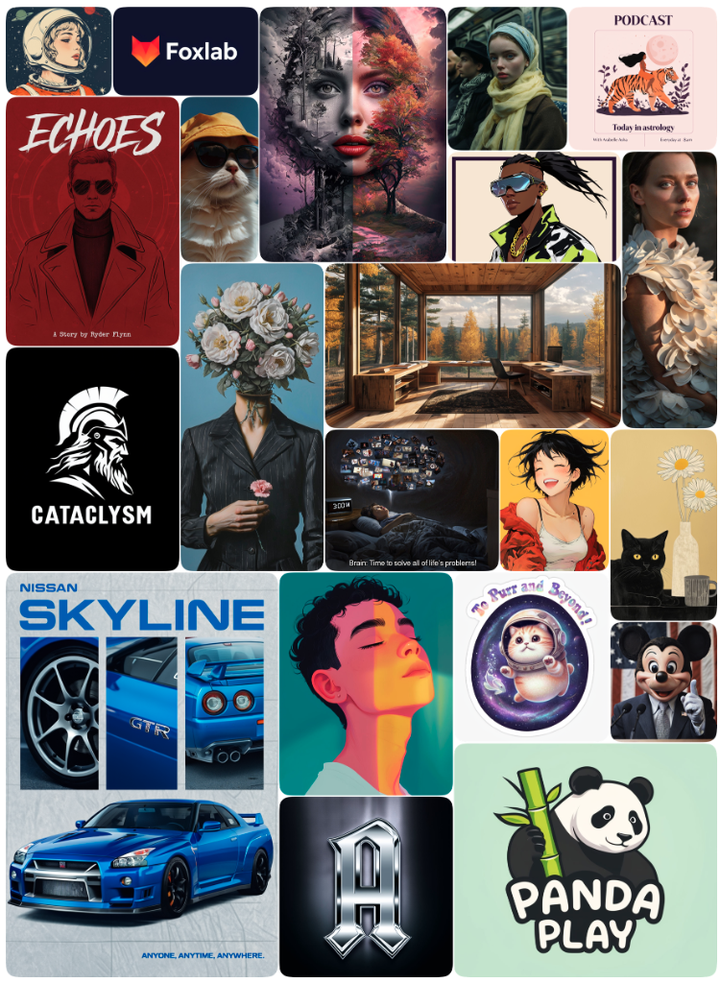

多级字幕可以帮助模型学习更好的语言概念层次结构。这允许模型不仅可以学习单词和图像之间的关系,还可以了解单词之间的语义关系和层次结构。因此,本文模型在响应较短 Prompt 时表现出多样性。而且,当在数据样本较少的数据集上进行训练时,例如在监督微调 (SFT) 阶段,多级字幕有助于防止过拟合,并显着增强了模型的泛化能力,将 SFT 数据集的良好图像属性推广到其他图像域。如图 4 所示,当给定一个简短而简单的 Prompt 时,本文模型可以生成不同的内容,在风格、颜色色调、种族和其他属性上有所不同。

训练稳定性

作者在模型训练后期观察到损失出现了尖峰,具体的表现是训练损失在没有 NaN 值的情况下变得异常大,导致当时的模不能够生成有意义的内容。作者尝试了几种策略来解决这个问题,包括使用梯度裁剪降低 Adam 优化器的 beta,并降低学习率。然而,这些方法最终都被证明是无效的。最终,作者发现下面的方法有助于缓解这个问题。

在训练期间,作者遍历了所有模型参数的梯度,并计算有多少梯度超过了特定的梯度值的阈值。如果这个计数值超过了预定义的计数阈值,就丢弃掉这个 training iteration,也就意味着不使用梯度更新权重。具体来讲,作者观察到,在发生损失的尖峰之前几次 training iteration,大值梯度的数量开始增加,并且在发生损失尖峰时达到了峰值。通过在损失尖峰之前记录多个 iterations 大值梯度的数量,将该值设置为阈值,然后按照这个阈值丢弃这个 training iteration。

这种方法不同于梯度裁剪。梯度裁剪只减少了梯度的大小,但不会改变权重更新的方向。因此,权重仍然可以向崩溃移动。通过丢弃整批梯度,本文这种方法避免了这种风险,并确保模型保持在稳定的训练轨迹。

1.4 图像字幕模型 PG Captioner 和评测框架 CapsBench

PG Captioner

对于字幕模型,作者使用标准的视觉语言架构[26],该架构由视觉编码器、视觉语言 adapter 和 decoder-only 的语言模型组成。作者参考[27]认为高分辨率视觉编码器对于图像的详细字幕非常重要。作者还发现模型大小与训练它到合理质量所需的数据量之间存在负相关:与更大的模型相比,小模型需要更多的数据来产生连贯的长字幕。对于模型训练,作者使用了合成数据生成工作流[28]和迭代自我改进[29]。

CapsBench

字幕评估是一个复杂的问题。字幕评估指标主要有 2 类。第 1 类是有参考的指标:BLEU、CIDEr、METEOR、SPICE。这些指标使用 GT 的字幕或一组字幕来计算相似度作为质量指标。第 2 类是无参考的指标:CLIPScore, InfoMetIC, TIGEr。这些方法使用来自参考图像或图像的多个区域的语义向量来计算所提出的字幕的相似性度量。这些方法的缺点是对于密集图像和长而详细的字幕,语义向量将不具有代表性,因为它们将包含太多概念。

受 DSG[30]和 DPG-bench[31]的启发,作者提出了一种用于图像字幕评估的反转方法。基于图像,作者在 17 个类别中生成 “是-否” 问答对:一般、图像类型、文本、颜色、位置、关系、相对位置、实体、实体大小、实体形状、计数、情感、模糊、图像伪影、专有名词 (世界知识)、调色板和颜色分级。大多数问题的答案是“是”的。在评估过程中,作者使用 LLM 仅根据候选字幕回答问题。可用的答案选项是 “yes”,”no” 和 “n/a”。然后将答案与参考答案进行比较以计算结果准确性。

本文正在发布 CapsBench[32],200 张图像和 2471 个问题,每张图像平均 12 个问题。图像代表了各种各样的类型:电影场景、卡通场景、电影海报、邀请、广告、休闲摄影、街道摄影、风景摄影和内部摄影。各种问题和图像可以对图像字幕系统进行全面评估。

1.5 图像质量的定性评价结果

图像逼真度评价

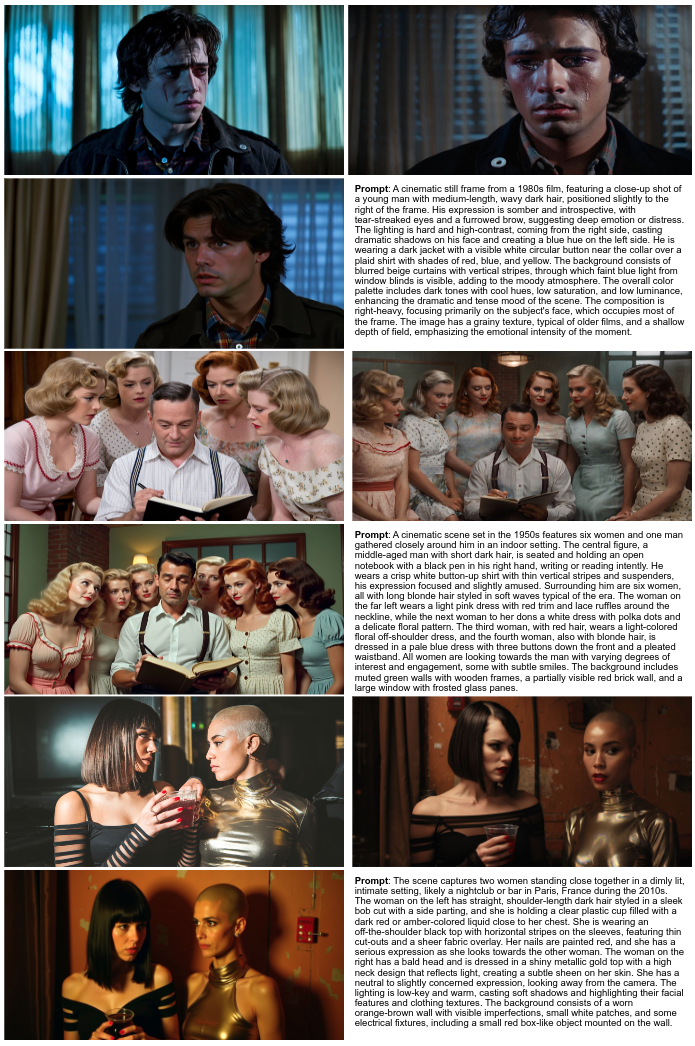

图 5,6 和 7 显示了 PGv3 和其他顶级模型的图像生成结果。在图 5 和图 6 的每个面板中,图像安排如下:左上角是 Idegram-2,右上角是 PGv3,左下角是 Flux-pro,右下角是 Prompt。

在放大以检查细节和纹理后,就能够观察到相对显著的差别。Flux-pro 生成的图像皮肤过度平滑,类似于含油或 3D 渲染,而不是逼真的描述。与 Flux-pro 相比,Idegram-2 提供了更真实的皮肤纹理,但在 Prompt 的遵从性方面表现不佳,通常在 Prompt 变长时缺少关键细节。相比之下,PGv3 在提示跟踪和生成逼真的图像方面都表现出色。此外,PGv3 表现出比其他模型更好的电影质量。

指令遵从评价

图 8 说明了包括 Idegram-2 和 Flux-pro 在内的 3 个例子,突出了与其他模型相比 PGv3 模型优越的指令跟踪能力。在每个 Prompt 中,彩色文本突出了其他模型无法捕获的具体细节,而 PGv3 始终遵从了这些细节。对特定颜色没有特别的含义。随着测试提示变长并且包含更详细的信息,PGv3 的优势变得尤为明显。作者将这个性能的提升归因于集成到模型内部的 LLM 以及先进的 VLM 字幕系统。

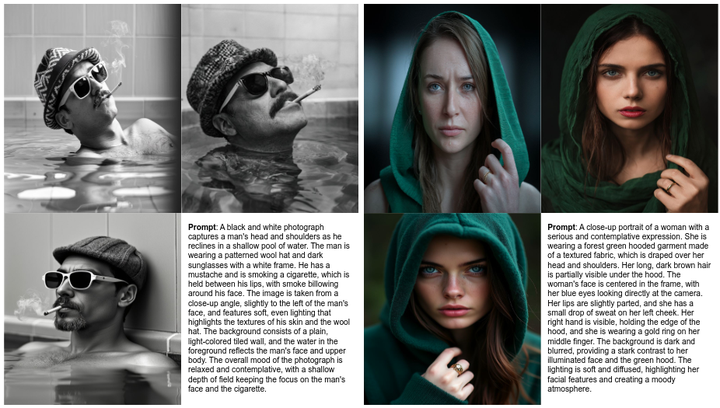

文本渲染评价

图 9 展示了 PGv3 的文本渲染能力。它可以生成各种设计类别的图像,包括海报、徽标、贴纸、书籍封面和演示幻灯片。值得注意的是,由于其强大的 Prompt 跟随和文本渲染能力,PGv3 可以通过自定义文本重现流行的主题或者创建新的主题。

RGB 色彩控制

PGv3 在生成的内容中实现了非常细粒度的颜色控制,超过了标准的调色板。PGv3 凭借其强大的 Prompt 跟随能力和专门的训练,使用户能够使用 RGB 值精确地控制图像中每个对象的颜色或区域,使其成为需要精准色彩匹配的专业设计场景的理想选择。如图 10 和图 11 所示,PGv3 接受整体调色板,自动将指定的颜色应用到适当的对象和区域,以及用户定义的特定对象的专用颜色值。

多语言提示输入

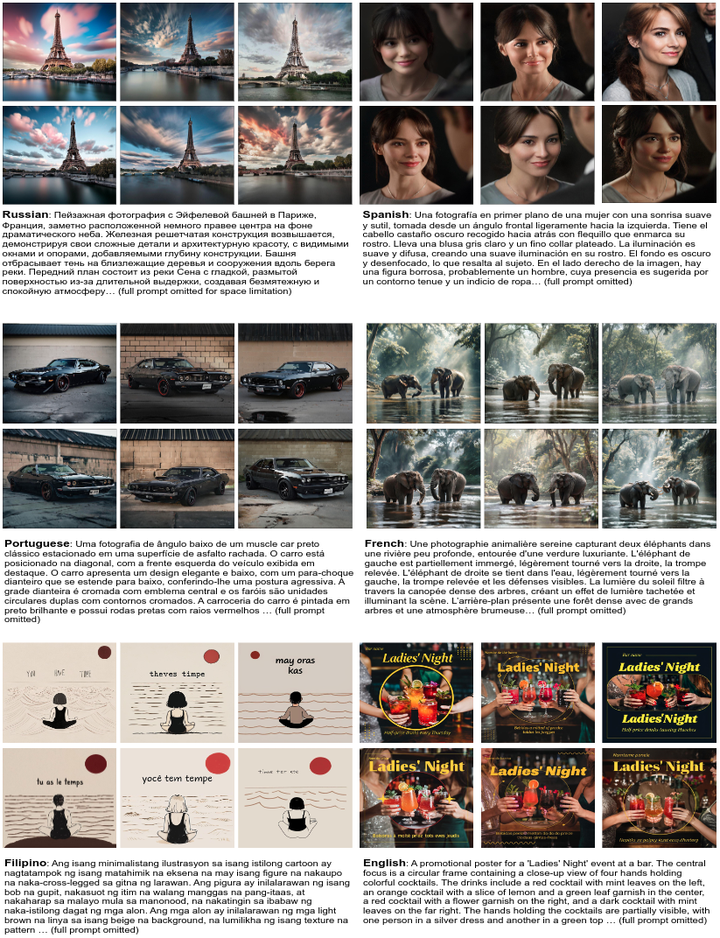

由于用作文本编码器的强大 LLM,PGv3 可以理解多种语言并在它们之间形成高度相关的 word representation,PGv3 可以自然地解释多种语言之间的 Prompts,作者发现这种多语言能力完全是通过一个小的多语言文本和图像对数据集实现的,数以千计的图像就足够了。

图 12 说明了模型在不同语言上的性能。在每个面板中,图像是从英语、西班牙语、菲律宾语、法语、葡萄牙语和俄语的提示生成的,从左到右排列。PGv3 始终能够产生符合每个相应语言中 Prompt 的内容。

1.6 图像质量的定量评价结果

ImageNet Benchmark

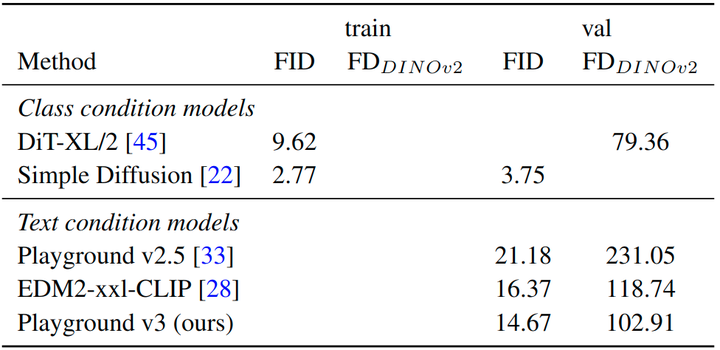

作者在两个 Benchmark,即:ImageNet 和 MSCOCO 上展示了结果,将 本文的 PGv3 模型的性能与其他最先进的模型进行比较。然而,ImageNet 和 MSCOCO 可能无法有效地捕获大规模文本到图像模型的综合性能,特别是考虑到 PGv3 等模型在提示跟踪方面的提升。

在图 13 中,作者将 PGv3 与之前的模型 PGv2.5 进行比较。作者遵循[15]的方法使用 a photo of a {class} 的格式,把 ImageNet 的类标签转化为 text condition。作者还在相同的设置中比较了 SoTA 方法 EDM2 模型。PGv3 在 FID 和 FD Dinov2 方面表现更好。作者还展示了 SoTA 类条件模型性能作为参考;通常,这些模型以类标签作为条件来实现更好的性能。

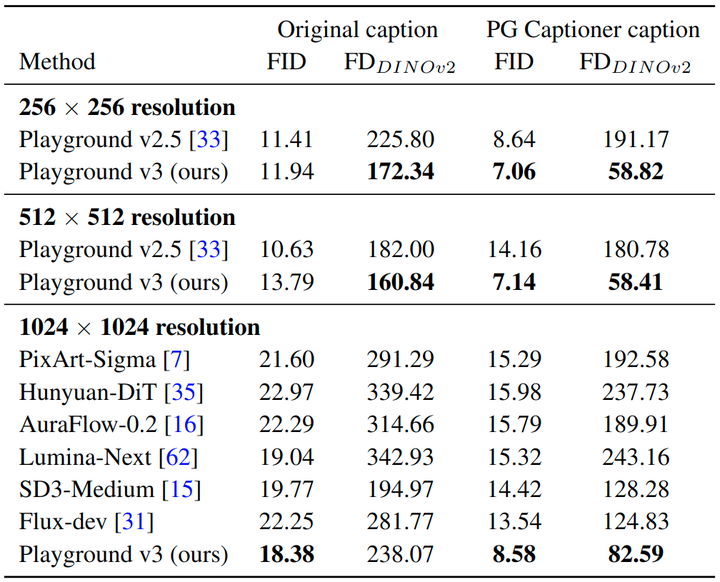

MSCOCO Benchmark

作者还使用 30k 个 Prompts 在 MSCOCO 验证集中评估本文模型。在图 14 中,作者使用 PG Captioner (长) 和原始 Prompts (短)。作者测量了 FID 和 FD Dinov2 中的模型性能,并发现 FD Dinov2是一个对物体形状更敏感的更好指标。作者在不同的训练阶段测量了本文模型,并与 256 和 512 分辨率的 PGv2.5 模型进行了比较。作者还在 1024×1024 分辨率下比较了其他 SoTA 模型。

从图中,本文模型在短 Prompt 和长 Prompt 中都取得了很好的性能,并且在 FD Dinov2 中显示出显著的改进,这表明几何和对象形状要好得多。作者只与 SoTA 开源模型进行比较,因为此评估需要从 PG Captioner 中采样原始标题和标题的 30k 图像。从结果中可以看到 PGv3 在两个标题集上都取得了最好的 FID 和 FD DINOv2。值得注意的是,使用 PG Captioner 字幕,本文的 1024px 模型显着优于 Flux-dev,表明颜色和形状泛化方面图像质量很强。

VAE 重建结果评估

作者将 VAE latent channel 大小从 4 增加到 16,以从低分辨率到更高分辨率的渐进方式训练 VAE。在图 15 中作者报告了在多个分辨率的验证集上的重建性能。从表中,与 SDXL 的 4 通道的 VAE 相比,本文 VAE 性能显着提高,在分辨率为 1024×1024 时,实现了 33.44 的 PSNR。

参考

^GLIDE: Towards Photorealistic Image Generation and Editing with Text-Guided Diffusion Models ^Scalable Diffusion Models with Transformers ^abThe llama 3 herd of models ^abElucidating the Design Space of Diffusion-Based Generative Models ^abHigh-Resolution Image Synthesis with Latent Diffusion Models ^Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer ^Learning Transferable Visual Models From Natural Language Supervision ^Mars: Mixture of auto-regressive models for fine-grained text-to-image synthesis ^Moma: Multimodal llm adapter for fast personalized image generation ^Diffusiongpt: Llm-driven text-to-image generation system ^Ella: Equip diffusion models with llm for enhanced semantic alignment ^Analyzing Individual Neurons in Pre-trained Language Models ^Analyzing Transformers in Embedding Space ^Scalable Diffusion Models with Transformers ^abScaling Rectified Flow Transformers for High-Resolution Image Synthesis ^Hunyuan-dit: A powerful multi-resolution diffusion transformer with fine-grained chinese understanding ^Pixart-alpha: Fast training of diffusion transformer for photorealistic text-to-image synthesis ^U-dits: Downsample tokens in u-shaped diffusion transformers ^RoFormer: Enhanced Transformer with Rotary Position Embedding ^Emu: Enhancing Image Generation Models Using Photogenic Needles in a Haystack ^Flow Matching for Generative Modeling ^Flow Straight and Fast: Learning to Generate and Transfer Data with Rectified Flow ^Scaling Rectified Flow Transformers for High-Resolution Image Synthesis ^Analyzing and Improving the Training Dynamics of Diffusion Models ^Playground v2.5: Three Insights towards Enhancing Aesthetic Quality in Text-to-Image Generation ^Improved Baselines with Visual Instruction Tuning ^Paligemma: A versatile 3b vlm for transfer ^Synth 2 : Boosting Visual-Language Models with Synthetic Captions and Image Embeddings ^Vila2: Vila augmented vila ^Davidsonian Scene Graph: Improving Reliability in Fine-grained Evaluation for Text-to-Image Generation ^ELLA: Equip Diffusion Models with LLM for Enhanced Semantic Alignment ^https://huggingface.co/datasets/playgroundai/CapsBench

公众号后台回复“数据集”获取100+深度学习各方向资源整理

极市干货

点击阅读原文进入CV社区

收获更多技术干货